データの傾向を示す際、折れ線グラフは非常に有用です。特に、気温のような時系列データに信頼区間を追加することで、データの変動範囲と信頼性を視覚的に表現できます。この記事では、実際の気温データを用いて、Rで折れ線グラフに信頼区間を追加する方法を、具体的なスクリプト例を交えて解説します。

ステップ1: 必要なパッケージのインストールと読み込み

折れ線グラフに信頼区間を追加するためには、ggplot2パッケージが便利です。まずはこのパッケージをインストールし、読み込みます。

install.packages("ggplot2")

library(ggplot2)

ステップ2: 実際の気温データの準備

ここでは、ある都市の過去数年間の月別平均気温データを使用します。

# 架空の気温データ

temperature_data <- data.frame(

year = rep(2015:2019, each = 12),

month = rep(1:12, times = 5),

temp = c(6, 7, 10, 15, 20, 25, 30, 29, 24, 18, 12, 8, 5, 6, 11, 16, 21, 26, 31, 30, 25, 19, 13, 9, 4, 5, 9, 14, 19, 24, 29, 28, 23, 17, 11, 7, 6, 7, 10, 15, 20, 25, 30, 29, 24, 18, 12, 8, 5, 6, 11, 16, 21, 26, 31, 30, 25, 19, 13, 9)

)

ステップ3: 月別平均気温と信頼区間の計算

月別の平均気温と信頼区間を計算します。

library(dplyr)

# 月別平均気温と標準誤差の計算

temp_summary <- temperature_data %>%

group_by(month) %>%

summarise(mean_temp = mean(temp), se = sd(temp) / sqrt(n()))

# 信頼区間の追加

temp_summary <- temp_summary %>%

mutate(lower = mean_temp - qt(0.975, df=n()-1) * se,

upper = mean_temp + qt(0.975, df=n()-1) * se)

信頼区間の追加のスクリプトの各部分の意味は次のとおりです。

-

mutate(...): dplyrパッケージのmutate関数は、既存のデータフレームに新しい列を追加するために使用されます。ここでは、lowerとupperという二つの新しい列を追加しています。

-

lower = mean_temp - qt(0.975, df=n()-1) * se: この式は、平均値から信頼区間の下限を計算します。qt(0.975, df=n()-1)は、自由度df(ここではデータポイントの数から1を引いた値)を持つt分布の97.5パーセンタイルを返します。これは、95%の信頼区間の下限を求めるために使用されます(両側のために2.5%を引きます)。seは標準誤差です。

-

upper = mean_temp + qt(0.975, df=n()-1) * se: この式は、平均値から信頼区間の上限を計算します。ここでもt分布の97.5パーセンタイルを使用して、95%の信頼区間の上限を求めます。

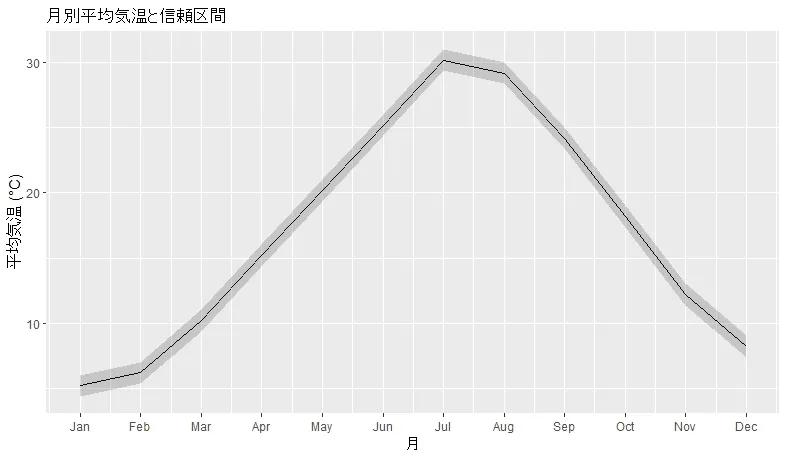

ここまでのスクリプトを実行すると次のようなグラフになります。

ステップ4: 折れ線グラフと信頼区間の追加

計算した平均気温と信頼区間を使用して、折れ線グラフに信頼区間を追加します。

ggplot(temp_summary, aes(x = month, y = mean_temp)) +

geom_line() +

geom_ribbon(aes(ymin = lower, ymax = upper), alpha = 0.2) +

scale_x_continuous(breaks = 1:12, labels = month.abb) +

ggtitle("月別平均気温と信頼区間") +

xlab("月") +

ylab("平均気温 (°C)") +

theme(panel.background = element_rect(fill = "white"))

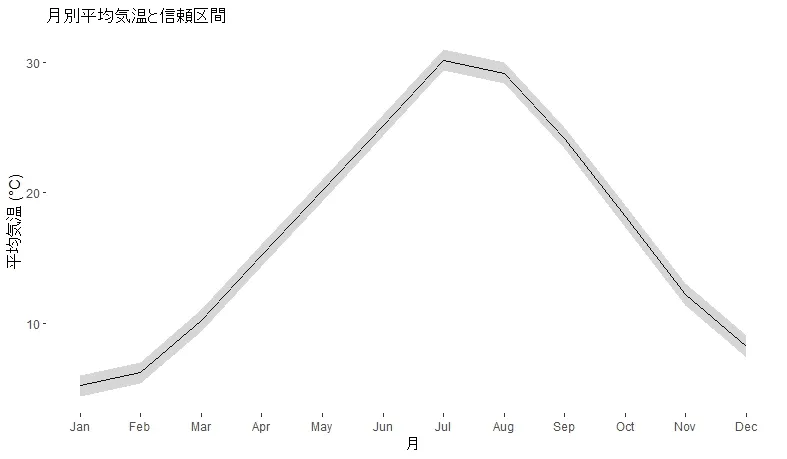

このコードは、月ごとの平均気温を折れ線グラフで描画し、geom_ribbonを使用して信頼区間を表現します。alphaパラメータは信頼区間の透明度を調整します。

ここまでのスクリプトを実行すると次のようなグラフになります。

まとめ

この記事では、Rとggplot2パッケージを使用して、実際の気温データに基づく折れ線グラフに信頼区間を追加する方法を紹介しました。データの準備から平均値と信頼区間の計算、グラフの作成までのステップを具体的なスクリプト例を交えて解説しました。

特殊なグラフ

2024/4/26

R言語でQQプロットを作成する方法

はじめに QQプロット(Quantile-Quantileプロット)は統計分析で非常に役立つツールです。これを使って、データセットが特定の理論分布に従っているかどうかを視覚的に評価することができます。R言語には、この種のプロットを簡単に作成できる強力なツールが用意されています。この記事では、R言語を使用してQQプロットを作成する基本的なステップを説明します。 必要なパッケージ QQプロットを描くためには、基本的にstatsパッケージが必要ですが、これはRの標準パッケージに含まれているため、特別なインストー ...

ReadMore

グラフのカスタマイズ

2024/4/17

Rでエラーバー付きのグラフを作成する方法

はじめに データの可視化において、エラーバーはデータの変動や不確実性を表現する重要な手段です。R言語を用いたグラフ作成においてエラーバーを追加する方法を学ぶことで、データの解釈をより深く行うことが可能になります。この記事では、基本的なエラーバーの追加方法から、カスタマイズする方法までを段階的に解説します。 エラーバーを含むグラフの重要性 エラーバーは、データ点のばらつきや測定の不確かさを表すのに役立ちます。科学研究や技術報告でよく見られるこの表現方法は、データの信頼性や有効性を視覚的に伝えるために不可欠で ...

ReadMore

グラフのカスタマイズ

2024/4/17

R言語でのグラフ作成:X軸とY軸のスケール比の設定方法

はじめに R言語はデータ分析と可視化に非常に強力なツールです。特にグラフ作成機能は多くのデータサイエンティストや研究者に利用されています。この記事では、R言語でグラフを作成する際にX軸とY軸のスケール比を設定する方法を詳しく解説します。スケール比を調整することで、データの比率や関係性をより正確に表現することが可能になります。 グラフの基本的な作成方法 まず、R言語で基本的なグラフを作成する方法から見ていきましょう。ここでは、plot() 関数を使用してシンプルな散布図を描きます。 # サンプルデータの生成 ...

ReadMore

特殊なグラフ

2024/4/18

R言語でバイオリンプロットを作成する方法:データの分布を視覚化

はじめに バイオリンプロットは箱ひげ図の概念を拡張したもので、データの分布密度も同時に表現できるグラフです。この記事では、R言語を用いてバイオリンプロットを作成する手順を、基本から応用まで丁寧に解説します。 バイオリンプロットとは? バイオリンプロットは、データの確率密度を視覚的に表現する方法の一つで、中央値や四分位数といった統計量だけでなく、データの分布形状も示すことができます。これにより、データの全体的な傾向をより詳細に把握することが可能になります。 Rでバイオリンプロットを作成する Rでは、ggpl ...

ReadMore

グラフのカスタマイズ

2024/4/18

R言語で箱ひげ図に平均値を追加する方法

はじめに 箱ひげ図はデータの分布、特に四分位数や極値を視覚的に表現する強力なツールですが、時には平均値を表示することでデータの理解をさらに深めることができます。この記事では、R言語を使用して箱ひげ図に平均値を追加する方法を解説します。 箱ひげ図とは? 箱ひげ図(Boxplot)は、データの中央値、四分位数、外れ値を表示し、データの分布を要約するのに役立ちます。しかし、平均値もまたデータの中心傾向を理解するのに重要な指標であり、これを箱ひげ図に追加することで、さらに多角的なデータ解析が可能になります。 Rで ...

ReadMore

統計学基礎

2025/2/27

多重共線性とは?統計分析への影響と対策、Rでの検出方法を徹底解説!

統計分析や機械学習において、説明変数(独立変数)同士が強い相関を持つこと は、回帰モデルの推定精度を低下させる可能性があります。 このような状況を 「多重共線性(Multicollinearity)」 と呼びます。 多重共線性が起こると何が問題か? ✅ 回帰係数の推定値が不安定 になり、解釈が難しくなる✅ 統計的な有意性(p値)が正しく評価できなくなる✅ モデルの予測精度が低下 し、新しいデータに対して適用しにくくなる 例えば、以下のようなデータセットを考えます。 ...

ReadMore

回帰分析

2025/2/26

偏回帰分析とは?基本概念から解釈、Rによる実装まで徹底解説!

統計分析において、「ある説明変数が目的変数に与える影響を評価したい」と考えることはよくあります。しかし、多くのデータには 複数の説明変数が同時に影響を及ぼしている ため、単純な単回帰分析では正しい評価ができないことがあります。 そこで活用されるのが 偏回帰分析(Partial Regression Analysis) です。 ✅ 偏回帰分析の主な目的 特定の変数が目的変数に与える影響を、他の変数の影響を除外した上で評価する 多変量データの中で、各説明変数の相対的な寄与度を明確にする 重回帰分 ...

ReadMore

統計学基礎

2025/2/26

ベイズ統計学とは?事前確率と事後確率を用いた推論の基礎からRでの実装まで徹底解説!

統計学において、「新しい情報を得たときに、既存の知識をどのように更新するか?」という問題は非常に重要です。その問題に答えるのがベイズ統計学 です。 ベイズ統計学(Bayesian Statistics) は、事前確率(prior probability)と新しいデータの尤度(likelihood)を組み合わせ、事後確率(posterior probability)を求めることで推論を行います。 例えば、以下のようなケースで活用されています。 ✅ 医療診断:「ある検査で陽性が出た場合、本当に病 ...

ReadMore

統計学

2025/2/26

統計学の歴史③:古代から現代まで、データ分析の進化と発展の軌跡

3. 現代統計学の発展と未来 3-1 コンピュータ革命と統計学 20世紀後半に始まったコンピュータ革命は、統計学の理論と実践に革命的な変化をもたらしました。計算能力の飛躍的向上により、それまで理論上は可能でも実行が困難だった複雑な統計的手法が実用化され、統計学の適用範囲と可能性は大きく拡大しました。 1940年代後半から50年代にかけて開発された初期のコンピュータは、主に軍事目的や科学計算のために使用されていましたが、すぐに統計的計算にも応用されるようになりました。1960年代になると、統計解析専用のソフ ...

ReadMore

統計学

2025/2/26

統計学の歴史②:古代から現代まで、データ分析の進化と発展の軌跡

2. 19世紀~20世紀前半:統計学の黄金期 2-1 統計学の学問的確立 19世紀後半から20世紀初頭にかけて、統計学は独立した学問分野として確立されていきました。この時期、統計学は記述的な段階から分析的・推測的な段階へと発展し、その理論的基盤が大きく強化されました。 この時代の統計学発展の中心となったのが、イギリスの優生学者・統計学者カール・ピアソンです。ゴルトンの研究を引き継いだピアソンは、1901年に「統計的研究のための数学的貢献」を発表し、その中で相関係数(ピアソンの積率相関係数)を定式化しました ...

ReadMore